Autor

David Fehrenbach

David ist Geschäftsführer von preML und schreibt über technologie- und geschäftsbezogene Themen im Bereich Computer Vision und maschinelles Lernen.

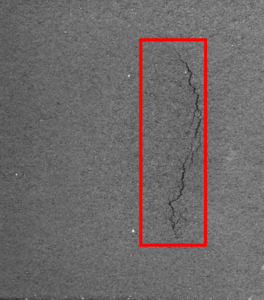

Wenn ich unsere visuellen Qualitätsprüfsysteme verkaufe, werde ich oft in einem sehr frühen Projektstadium gefragt, wie zuverlässig die Fehlererkennung ist. In der Regel benötigen wir einen Proof of Concept mit einem ersten Machine Learning (ML) Modell, um diese Frage zu beantworten. Und die quantitative Antwort auf diese Frage wird dann in Form von Leistungsmetriken (engl. Performance Metrics) ausgedrückt. Dieser Blog-Beitrag gibt einige Hintergrundinformationen zur Bedeutung der Leistungskennzahlen, die wir bei der Objekterkennung anbieten, mit einigen Beispielen aus der Risserkennung in der Stahlproduktion:

Bild 1: Riss mit Bounding Box bei Objekterkennung – preML GmbH

Ausflug in Machine Learning

Im Folgenden genügt es zu verstehen, dass die Ausgabe eines einfachen ML-Klassifikationsmodells eine Vorhersage ist, die auf Mustern oder Beziehungen beruht, die das Modell aus einem Trainingsdatensatz gelernt hat. In unserem Beispiel würde der Trainingsdatensatz aus den Bildern der Teile bestehen, auf denen wir Risse markiert (annotiert) haben. Neben dem Trainingsdatensatz gibt es in der Regel noch einen zweiten Datensatz, den Testdatensatz, mit der gleichen Art von Daten und Annotationen. Die Leistung eines ML-Modells wird durch den Vergleich seiner Vorhersagen auf dem ungesehenen Testdatensatz mit den Annotationen bestimmt, in unserem Beispiel, ob die Qualitätsabteilung sagen würde, dass es ein Riss ist oder nicht.

Problem

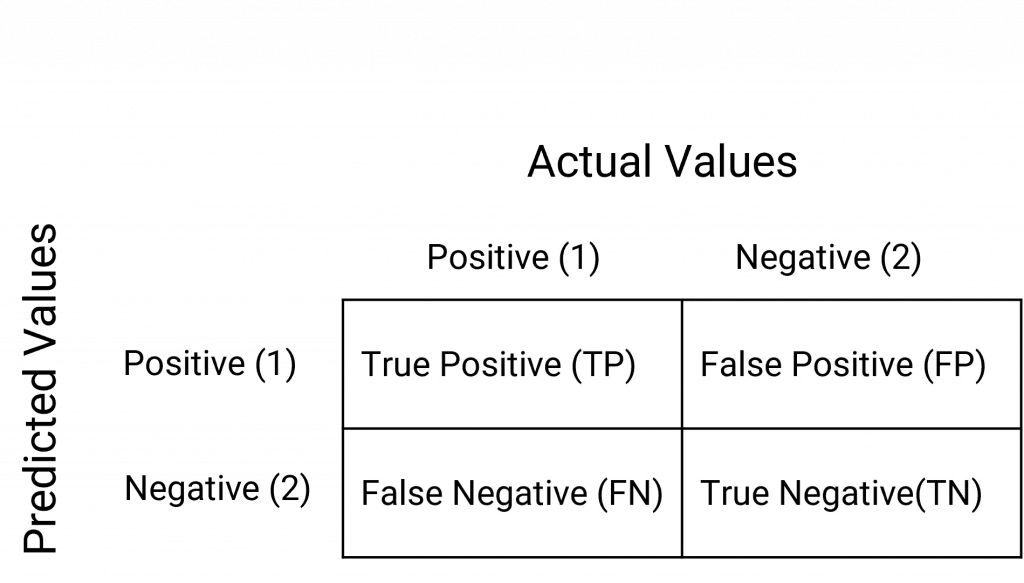

Hier fängt es an, kompliziert zu werden. Bei den einfachsten ML-Modellen müssen wir mindestens vier Arten von Ergebnissen berücksichtigen. Alle Fälle, in denen das Modell korrekt positive Ergebnisse vorhergesagt hat (TP), alle Fälle, in denen das Modell korrekt negative Ergebnisse vorhergesagt hat (TN), alle Fälle, in denen das Modell positive Ergebnisse vorhergesagt hat, die aber tatsächlich negativ waren (FP) und alle Fälle, in denen das Modell negative Ergebnisse vorhergesagt hat, die aber tatsächlich positiv waren (FN). Dies wird auch als „Konfusionsmatrix“ bezeichnet.

Image 2: Confusion Matrix

Erste Metriken

Es gibt viele verschiedene Metriken, aber in der Regel präsentieren wir unseren Kunden vier Metriken für ein Objekterkennungsmodell: Precision, Recall, AP@50 und AP@50-95:

Precision: Precision ist ein Maß dafür, wie genau die positiven Vorhersagen eines Modells sind. Im Zusammenhang mit der Risserkennung wäre die Präzision das Verhältnis der korrekt erkannten Risse zu allen als Risse vorhergesagten Fällen. Mit anderen Worten, sie gibt an, wie viele der vorhergesagten Risse tatsächlich richtig positiv sind.

Nehmen wir zum Beispiel an, Ihr Risserkennungsmodell sagt voraus, dass es 10 Risse in einem Stahlblech gibt, aber bei der manuellen Inspektion stellen sich nur 7 davon als tatsächliche Risse heraus. In diesem Fall würde die Genauigkeit 7/10 oder 0,7 betragen, was bedeutet, dass 70 % der vorhergesagten Risse echte positive Ergebnisse sind.

Recall: Recall, auch bekannt als Sensitivität oder True-Positive-Rate, misst, wie gut ein Modell alle positiven Instanzen erfasst. Bei der Risserkennung ist Recall (übersetzt vielleicht als Wiederfindungsrate) das Verhältnis der korrekt erkannten Risse zu allen tatsächlich vorhandenen Rissen im Stahlblech. Sie gibt an, wie viele der tatsächlichen Risse erfolgreich erkannt wurden.

Wenn es beispielsweise 15 tatsächliche Risse in einer Stahlplatte gibt und das Modell 10 davon erkennt, wäre der Recall 10/15 oder etwa 0,67, was bedeutet, dass das Modell etwa 67 % der tatsächlichen Risse erfasst hat.

Precision-Recall Trade-Off: Es ist wichtig zu verstehen, dass kein ML-Algorithmus selbstständig kategorische Entscheidungen trifft. Stattdessen geben sie eine Wahrscheinlichkeit oder „Confidence“ für eine Klassifizierung aus. Wir verwenden Prozentsätze, um quasi das Vertrauen (eng. Confidence) auszudrücken. Wir sagen zum Beispiel, dass ein Bild den Ergebnissen des Modells nach, mit 85%iger Wahrscheinlichkeit einen Riss enthält. In der Praxis legen wir einen Schwellenwert (engl. Threshold) fest, um eine kategorische Entscheidung auf der Grundlage des Confidence Wertes zu treffen. Wir könnten zum Beispiel festlegen, dass alle Erkennungen mit einer Confidence von mehr als 50 % als Risse gelten. Wenn wir diesen Threshold ändern, verbessern wir entweder die Precission oder den Recall, während wir das andere beeinträchtigen.

Übergang zur Objekterkennung

Das Verständnis der Konzepte von Precision und Recall bildet die Grundlage für die Bewertung umfassenderer Metriken, die im Zusammenhang mit der Objekterkennung von entscheidender Bedeutung sind. Wie bereits erwähnt, identifizieren und lokalisieren wir bei der Objekterkennung mehrere Objekte (z. B. einen Riss) in einem Bild oder Videobild.

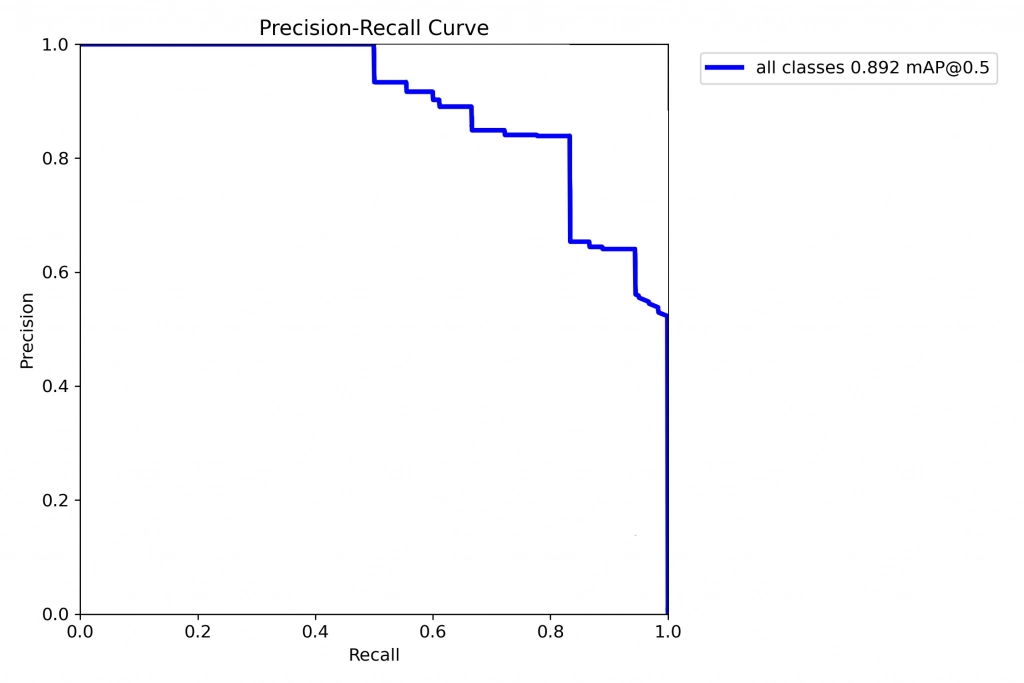

Average Precision (AP): Durch die Berechnung von Precision und Recall für alle Confidences zwischen 0 % und 100 % können wir ein Diagramm erstellen, das alle möglichen Kombinationen von Precision und Recall zeigt. Um eine Metrik zu erhalten, die Precision und Recall zusammenfasst, können wir einfach die Fläche unter dieser Kurve berechnen. Dieser Wert wird als Average Precision (AP) (engl. Durchschnittliche Präzision) bezeichnet.

Image 2: Precision-Recall Kurfe für einen Objektdetektions Algorithmus – preML GmbH

Intersection over Union (IoU):

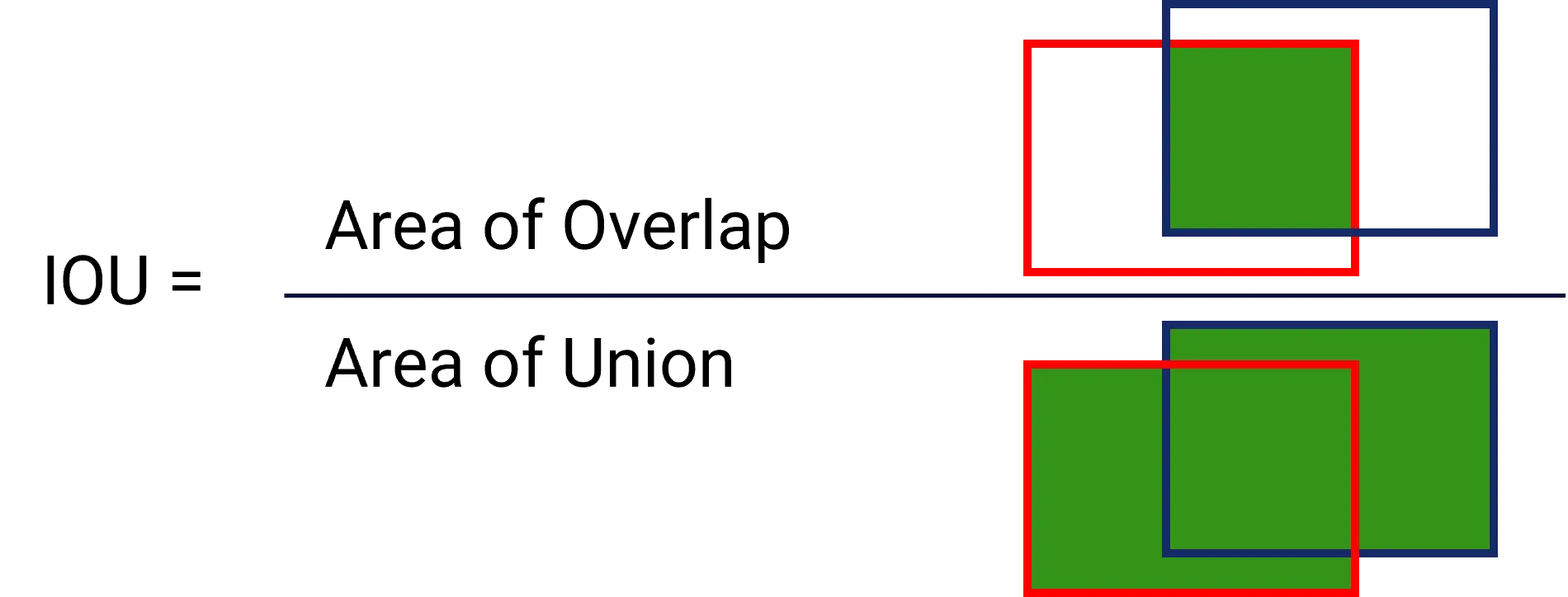

Die Vorhersage eines Objekterkennungsmodells sagt den Ort des Objekts im Bild anhand von Koordinaten voraus. Wenn das Modell ausgewertet wird, wissen wir, wie weit eine Vorhersage von der Grundwahrheit (in Form der Annotation) entfernt ist. Dies wird oft als ein Kasten um das Objekt herum dargestellt. Die Intersection over Union (IoU) ist eine Zahl, die den Grad der Überlappung zwischen zwei Boxen, der Grundwahrheit und der Vorhersage, angibt. Die Idee ist, die Metrik immer dann zu bestrafen, wenn die Vorhersage den Bereich innerhalb der Grundwahrheit nicht vorhersagen kann oder wenn die Vorhersage die Grundwahrheit überlappt. Ein IoU von 1 würde also bedeuten, dass sich die Felder perfekt überlappen, ein IoU von 0 bedeutet, dass es überhaupt keine Überlappung gibt.

Image 3: IoU Visualisierung. Rote Boxen sind die Grundwahrheit, vs. Blaue Boxen die Vorhersage des Objektdetektions Algorithmus – preML GmbH

Und das große Finale…

AP@50: Average Precision mit 50 (mAP@50) ist eine Metrik, die häufig bei Objekterkennungsaufgaben verwendet wird, und wir erwähnen diesen Wert in der Regel als denjenigen, der beispielsweise in einer Proof-of-Concept-Phase beachtet werden sollte. Dabei berücksichtigt man die Precision und den Recall bei einem Confidence Threshold und berechnet die durchschnittliche Präzision. Die Angabe „@50“ zeigt an, dass die Boxen mindestens 50 % Überlappung aufweisen müssen (siehe IoU), um als echt positiv (TP) zu gelten.

Im Zusammenhang mit der Risserkennung würde diese Metrik bewerten, wie gut das Modell bei verschiedenen Confidence Level bei der Vorhersage von Rissen abschneidet. Dabei wird der Durchschnitt der Precicion-Recall Kurve bei einer Confidence Threshold von 50 % gebildet.

AP@50-95: Ähnlich wie AP@50 berechnet AP@50-95 die durchschnittliche Precision, berücksichtigt aber einen Bereich von IoU-Schwellenwerten von 50 % bis 95 %. Diese Metrik bietet eine strengere Bewertung der Leistung des Modells, indem höhere IoU Thresholds berücksichtigt werden.

Zusammenfassung

Man könnte sagen, ein gutes Modell sollte in praktischen Anwendungen immer ein Gleichgewicht zwischen hoher Precision und hohem Recall erzielen. Ein Modell mit hoher Precision, aber niedrigem Recall könnte einige wichtige Risse übersehen, während ein Modell mit hohem Recall, aber niedriger Precision viele falsch positive Ergebnisse liefern könnte. Wir verwenden die durchschnittliche Precision, um eine kombinierte Metrik aus Precision und Recall zu erstellen. Die Entscheidung, welcher Metrik der Vorzug zu geben ist, hängt von den spezifischen Anforderungen der Aufgabe und den möglichen Folgen fehlender Erkennungen oder falscher Alarme in der Produktion ab.

Denken Sie auch daran, dass die Performance mit der Daten- und Annotationsqualität interagieren. Wenn das Modell sehr gut ist, wird es Fehler finden, die der Annotator in der Annotationsphase übersehen haben könnte.

Ich denke, das war’s für den Moment!

Ich freue mich auf Rückmeldungen zu diesem Artikel

Autor

David Fehrenbach

David ist Geschäftsführer von preML und schreibt über technologie- und geschäftsbezogene Themen im Bereich Computer Vision und maschinelles Lernen.